TL; DR (要約)

AIが医師の「五感」を拡張し、心電図や心音など「時間」の中に隠された病のサインを捉える技術のまとめです。

24時間休みなく働く、超人的なモニタリングパートナーの能力を概観します。

① 時系列解析

(時間の流れを読む)

RNNやLSTM、Transformerといったモデルが、心電図の波形のように順序が重要なデータを読み解きます。

② 異常検知

(いつもと違うを捉える)

膨大なデータから「正常」を学習し、逸脱した危険なサイン(不整脈など)を自動で見つけ出します。

③ 音響解析

(音を“見て”診断する)

心音や咳の音を「画像(スペクトログラム)」に変換し、画像認識AI(CNN)で解析。聴診器が進化します。

④ ウェアラブル連携

(日常に医療を溶け込ます)

Apple Watch等と連携し24時間モニタリング。病気の予防や在宅での遠隔管理を実現します。

この章の学習目標と前提知識

聴診器から耳に伝わる心音の微細な響き、モニターを流れる心電図の波形から一瞬で異常なパターンを読み取る経験、あるいは患者さんの咳の音色からその湿り気や深さを感じ取ること。これらは、日々の臨床で私たちが駆使する、経験に裏打ちされた、まさに職人芸とも言えるスキルだと思います。私たちの脳は、こうした一瞬のスナップショットから、驚くほど多くの情報を引き出し、高度な判断を下しています。

しかし、現代医療が向き合うデータは、もはやこうした「点」や「静止画」だけではありません。ホルター心電図が刻む24時間の心臓の鼓動、ICUモニターが吐き出す秒単位のバイタルサイン、そしてApple Watchのようなウェアラブルデバイスが私たちの日常生活から集め続ける膨大な生体データ。これらは、一人の患者さんの健康状態を、途切れることのない「線」として、あるいは「24時間365日の動画」として描き出します。

もし、この果てしなく続く動画を、瞬きもせず、完璧な記憶力で見守り続け、人間の目や耳では捉えきれない微細な変化や、ごく稀にしか現れない危険なサインを検知してくれる、そんな不知疲れのパートナーがいたとしたら、私たちの診療はどう変わるでしょうか。

本講座「作って理解する!シリーズ医療×生成系AI」の第7回では、まさにそのパートナー、つまり私たちの五感をデジタルの領域で拡張してくれるAI技術に光を当てます。今回のテーマは、心電図や脳波といった「生体信号」、そして心音や呼吸音といった「音響データ」の解析です。これらはすべて「時間」という共通の軸を持つ時系列データであり、その時間の中に隠されたパターンを読み解くことは、AIが最も得意とする領域の一つなのです。

この記事では、「第7回: 生体信号・音響データの解析とモニタリング」で学ぶ4つの主要なトピックの全体像を、いわば旅の地図としてダイジェストでご紹介します。

なお、本記事は各トピックの概要を掴んでいただくためのサマリーです。時系列データを扱うAIモデルの具体的な理論やPythonによる実装方法については、今後の記事で各項目(7.1, 7.2など)を深く掘り下げて解説していきますので、ご安心ください。

7.1 時間の流れを読むAI:RNN、LSTM、Transformerによる時系列データ解析の基礎

心電図のP波、QRS波、T波という一連の流れ。あるいは、ICUでモニタリングされる血圧や心拍数の連続的な変動。これら医療データの多くは、個々の測定値が独立しているのではなく、「時間」という軸の上で互いに関連しあう、時系列データとしての性質を持っています。QRS波の前にP波があるからこそ意味があるのであり、その順序が逆転すれば、それは全く異なる臨床的意味を持ちますよね。

このような「時間の流れ」や「順序」に意味があるデータを、AIはどのように読み解くのでしょうか。そのために開発されてきた、代表的な3つのAIアーキテクチャをご紹介します。

① RNN (Recurrent Neural Network):短期記憶を持つ読書家

時系列データを扱うための、最も古典的で基礎的なモデルが RNN(再帰型ニューラルネットワーク) です。その本質は、過去の情報を「記憶」しながら、データを一つずつ順番に処理していく点にあります。

直感的なイメージ:

RNNを、1時刻前の情報だけを覚えている読書家だと考えてみてください。心電図のデータを1点ずつ読み進めながら、常に「直前の波形はどうだったか」という短期記憶を頼りに、次の波形を解釈します。

数式で概念的に表現すると、ある時刻 \(t\) の状態 \(h_t\) は、その時刻の入力 \(x_t\) と、一つ前の時刻の状態 \(h_{t-1}\) の両方から計算されます。

\[ h_t = f(W_{hh}h_{t-1} + W_{xh}x_t) \]

この単純な記憶の仕組みは強力ですが、弱点もあります。時系列が非常に長くなると、最初の頃の情報を忘れてしまう「長期依存性の問題(勾配消失問題)」です。まるで伝言ゲームのように、情報が伝わるうちに内容が薄れていってしまうイメージです。

↓こちらも参照!

② LSTM (Long Short-Term Memory):賢い記憶の門番

RNNの「忘れっぽい」という弱点を克服するために登場したのが、LSTM(Long Short-Term Memory) です。これは、RNNの改良版であり、より高度な記憶の仕組みを持っています。

LSTMの画期的な点は、単に情報を垂れ流すのではなく、「ゲート」と呼ばれる仕組みを使って、記憶すべき情報、忘れるべき情報、出力すべき情報を、状況に応じてコントロールするところにあります。

直感的なイメージ:

LSTMの内部には、「忘却ゲート」「入力ゲート」「出力ゲート」という3人の賢い門番がいると想像してください。

このゲート機構のおかげで、LSTMは「このP波の形は重要だから、しばらく覚えておこう」「この部分はただのノイズだから、忘れてしまおう」といった、よりインテリジェントな記憶の取捨選択ができます。その結果、RNNよりもはるかに長い時系列データの中にある、複雑なパターンを学習することが得意なのです。

↓こちらも参照!

このRNNやLSTMの詳しい仕組み、そしてPython (PyTorch) を使ってゼロから実装する方法に興味が湧いた方は、ぜひ「[Series P] Medical AI with Python:Pythonで学ぶ人工知能の理論と実装」の第15回「PyTorchで系列データ分析」を覗いてみてください。RNN、LSTM、そしてその派生であるGRUについて、理論から医療データへの応用までをハンズオンで学ぶことができます。

③ Transformer:時間と空間を超える鳥の目

RNNとLSTMが、いわば地面を歩きながら一歩一歩データを処理していくアリの視点だとすれば、Transformerは、空から全体を一度に見渡す鳥の視点です。

自然言語処理の世界で革命を起こしたこのモデルは、時系列データの解析においてもその力を発揮します。Transformerは、データを順番に処理するのではなく、その心臓部であるAttention機構を使って、系列内のすべてのデータ点間の関連性を一気に計算します。

直感的なイメージ:

優秀な循環器内科医が、12誘導心電図の全体を瞬時に見て、「V1誘導のこの僅かな波形の乱れは、実は遠く離れたaVF誘導の変化と関連している」と見抜くようなものです。Transformerは、ホルター心電図の開始時点のイベントが、数時間後のイベントにどう影響しているか、といった長期的な関連性を、距離に関係なくダイレクトに捉えることができます。これが、RNNやLSTMとは根本的に異なるアプローチです。

↓こちらも参照!

このTransformerの心臓部であるAttention機構のさらに詳しい解説や、その計算の全容については、「[Series P] Medical AI with Python:Pythonで学ぶ人工知能の理論と実装」の第22回「生成モデル入門① 自己回帰モデル 「Transformer」徹底理解!」で徹底的に解説していますので、より深く学びたい方はそちらもご参照ください。

まとめ:どのモデルをいつ使うか?

これら3つのモデルは、それぞれに長所と短所があります。

| モデル | データ処理の方法 | 長期記憶 | 特徴 |

|---|---|---|---|

| RNN | 逐次的(1点ずつ) | 苦手 | シンプルで計算が速いが、長期の依存性を忘れがち。 |

| LSTM | 逐次的(1点ずつ) | 得意 | ゲート機構により長期の依存性を学習可能。RNNより複雑。 |

| Transformer | 並列的(全体を一度に) | 非常に得意 | Attention機構により、距離に関係なく関連性を捉えられる。計算コストが高い。 |

どのモデルを選択するかは、解きたい課題の性質(例えば、心拍のリアルタイム予測か、24時間全体のデータ解析か)、データの長さ、そして利用できる計算リソースによって決まります。このセクションでは、まずこれらの基本的な選択肢があることを、ぜひ覚えておいてください。

7.2 心電図・脳波等の生体信号からの異常検知モデル

さて、前のセクションで時系列データを読み解くためのAIの「脳」にあたるモデル(RNN, LSTM, Transformer)を見てきました。では、その脳を使って、私たちはどんな具体的な臨床課題を解決できるのでしょうか?

その最も強力な応用先の一つが、異常検知(Anomaly Detection)です。これは、膨大なデータの中から「いつもと違う」ものを見つけ出す技術です。干し草の山から一本の針を探し出すように、あるいは延々と続く正常な心拍の中から、たった一度だけ現れた危険な不整脈を捉えるような、まさにAIの真骨頂が発揮される分野と言えるでしょう。

異常検知は、どうやって「いつもと違う」を見つけるのか?

基本的な考え方は非常にシンプルです。それは、まず「正常とは何か」をAIに徹底的に学習させ、その「正常」のパターンから大きく逸脱したものを「異常」としてフラグを立てる、というものです。このアプローチには、古典的な統計的手法から、より高度な深層学習モデルまで、いくつかの段階があります。

アプローチ①:統計的な外れ値検出(Zスコア法)

最もシンプルな方法は、統計学の「外れ値検出」を利用するものです。例えば、あるデータ点が、その周辺のデータの平均値から、標準偏差のいくつ分だけ離れているかを示すZスコアという指標を使います。

\[ Z = \frac{x – \mu}{\sigma} \]

この式で、\(x\) はあるデータ点、\(\mu\) (ミュー) は局所的な平均値、\(\sigma\) (シグマ) は局所的な標準偏差を表します。Zスコアの絶対値が、例えば3を超えるような極端に大きな値を示した場合、そのデータ点は「外れ値」、つまり「異常」である可能性が高いと判断します。

この方法は、突然のスパイク状のノイズや、瞬間的な異常を検出するには有効です。しかし、波形全体の「形」が微妙に歪んでいる、といった複雑な異常を捉えるのは苦手です。

アプローチ②:AIによる「再構成」を利用した異常検知

そこで、より高度なAIモデル、特にオートエンコーダ(Autoencoder) と呼ばれるニューラルネットワークが活躍します。

直感的なイメージ:

オートエンコーダを、「熟練の贋作画家」と「鋭い鑑定士」が一体になったAIだと想像してください。このAIには、正常な心電図データだけを大量に見せて学習させます。その学習目標は、入力された正常な心電図を、一度ぐちゃっと小さな情報(潜在変数)に要約し、そこから再び元の綺麗な心電図を完璧に復元(再構成)することです。

このAIは「正常な心電図の復元」しか練習していないので、未知の「異常な心電図」が入力されると、うまく復元できずに歪な波形を出力してしまいます。その結果、元の異常データと、AIが復元しようとして失敗したデータとの間に、大きな再構成誤差(Reconstruction Error)が生まれます。この誤差が、設定したしきい値を超えた時、システムは「異常を検知した」と判断するのです。

臨床応用への道とPythonによるシミュレーション

この異常検知技術は、多くの臨床現場でその価値を発揮し始めています。

- 不整脈の自動検出: 私もホルター心電図の判読には多くの時間を費やしますが、AIが膨大なデータの中から心房細動や危険な期外収縮といった不整脈の候補だけを提示してくれるだけでも、業務の質と効率は劇的に向上するはずです。見落としのリスクを減らし、より重要な判断に集中できるようになります。

- てんかん発作の予兆検知: てんかんを持つ患者さんやご家族にとって、発作を事前に予知できることは、生活の質を大きく変える可能性があります。長時間の脳波(EEG)モニタリングデータから、AIが発作の数分~数時間前の微細な変化を捉えることを目指した研究は、まさに希望の光と言えるでしょう。

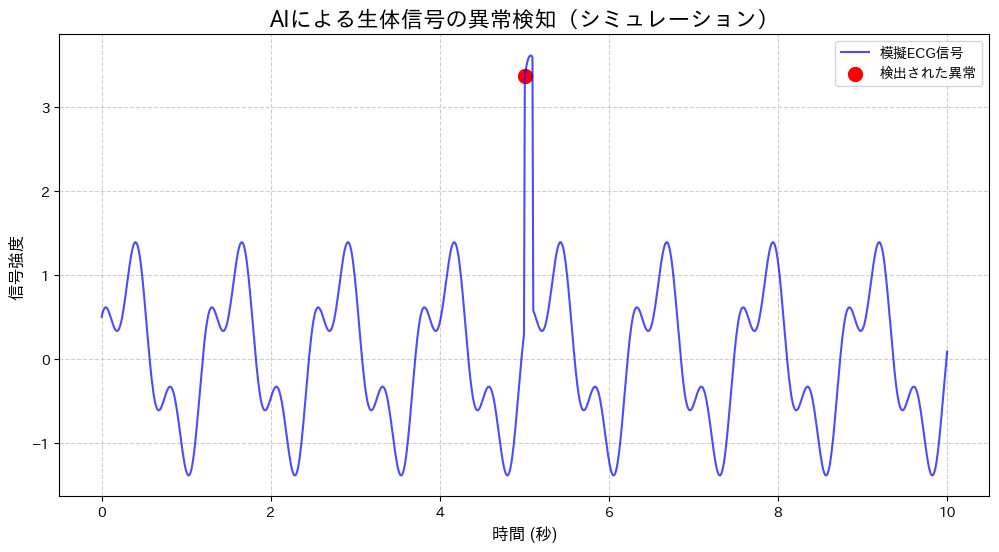

では、この異常検知の基本的な考え方を、実際にPythonコードで視覚化してみましょう。ここでは、AIモデルの訓練をする代わりに、先ほど説明した統計的な異常検知(Zスコア法)の基本をシミュレーションしてみます。

【実行前の準備】以下のコードで日本語のグラフを表示させるには、あらかじめターミナルやコマンドプロンプトで pip install japanize-matplotlib を実行してライブラリをインストールしてください。また、numpy, pandas, matplotlibも必要です。

graph TD

A["開始"] --> B["1. 模擬データを準備

(異常を含む時系列データを作成)"];

B --> C["2. 異常を検知

(移動Zスコア法でしきい値を超える点を特定)"];

C --> D["3. 結果を可視化

(元の信号と検出した異常点を重ねてグラフ表示)"];

D --> E["終了"];

# 必要なライブラリをインポートします

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import japanize_matplotlib # 日本語表示を有効化

# --- サンプル心電図(ECG)データの生成 ---

# np.linspaceは、指定した範囲で等間隔の数値を生成します (ここでは0から10まで1000点)

t = np.linspace(0, 10, 1000)

# np.sinとnp.cosを組み合わせて、心電図のような周期的な波形を模擬的に作成します

ecg_signal = np.sin(t * 5) + 0.5 * np.cos(t * 15)

# --- 異常の注入 ---

# データの特定の位置に、意図的に異常な値を加えます

# ここでは500番目から510番目のデータ点を異常とします

ecg_signal[500:510] += 3.0

# --- 異常検知(移動Zスコア法によるシンプルな実装) ---

# pandasのSeries形式に変換すると、高度なデータ操作が容易になります

s = pd.Series(ecg_signal)

# window=20は、20個のデータ点を1つのグループとして扱うことを意味します

rolling_mean = s.rolling(window=20).mean() # 移動平均を計算

rolling_std = s.rolling(window=20).std() # 移動標準偏差を計算

# Zスコアは、平均からどれだけ離れているかを標準偏差で割った値です。外れ値の検出に使われます

z_scores = (s - rolling_mean) / rolling_std

# Zスコアの絶対値が3より大きい点を「異常」と判定します

anomalies = s[np.abs(z_scores) > 3]

# --- 結果の可視化 ---

# グラフの描画エリアを作成します (横12インチ, 縦6インチ)

plt.figure(figsize=(12, 6))

# 元のECG信号を青い線でプロットします

plt.plot(t, ecg_signal, label='模擬ECG信号', color='blue', alpha=0.7)

# 検出された異常点を赤い点('o')でプロットします (s=100は点のサイズ)

plt.scatter(t[anomalies.index], anomalies.values, color='red', s=100, label='検出された異常')

# グラフのタイトルを設定します

plt.title('AIによる生体信号の異常検知(シミュレーション)', fontsize=16)

# X軸のラベルを設定します

plt.xlabel('時間 (秒)', fontsize=12)

# Y軸のラベルを設定します

plt.ylabel('信号強度', fontsize=12)

# 凡例(ラベルの説明)を表示します

plt.legend()

# グリッド線を表示します

plt.grid(True, linestyle='--', alpha=0.6)

# グラフを表示します

plt.show()

このコードはシンプルな統計的手法でしたが、実際のAIモデル、例えば先ほど紹介したオートエンコーダは、この「正常からのズレ」を、より複雑で多次元的なパターンのレベルで学習していくわけです。これにより、単なる数値の外れ値だけでなく、波形の「形」そのものの異常性を捉えることが可能になります。

7.3 心音・呼吸音・咳の音響解析による診断支援AIの開発

これまでは心電図や脳波といった、センサーで捉える「電気信号」の世界を見てきました。ここで少し視点を変えて、私たちの耳が日常的に捉えている、アナログで豊かな情報源である「音」の世界に目を向けてみましょう。

聴診器を胸に当て、全神経を集中させて心音のⅠ音・Ⅱ音の切れや、その間に潜む雑音の有無を聴き分ける。あるいは、患者さんの咳払い一つで、その湿り気や深さから痰の絡み具合を推測する。これは、長年の経験と訓練によって培われる、医療における最も根源的で重要なスキルの一つだと思います。しかし、この「聴く」という行為は、その日の体調や周囲の環境によっても左右され、所見の記録や他者との共有が難しい、という側面も持っています。

もし、この聴診というアートに、AIというサイエンスを融合させ、誰でもアクセス可能な客観的データとして扱えるようになるとしたら、どうでしょう。

音を「画像」に翻訳する魔法:スペクトログラム

AIに音を解析させる上で、最も重要で画期的なアプローチは、音の波形データを「画像」に変換してしまうことです。AIは人間のような耳を持ちませんが、画像からパターンを認識する「目」は、今や人間を凌駕するほどの性能を持っています。ならば、音をAIの得意な画像として見せてやろう、というわけです。

この魔法の翻訳技術が、スペクトログラムの作成です。

スペクトログラムとは?

直感的なイメージ:

スペクトログラムを、「音の楽譜」あるいは「音のレシピ」だと想像してみてください。この画像は、以下の3つの情報から成り立っています。

- 横軸: 時間

- 縦軸: 音の高さ(周波数)

- 色の濃淡: 音の強さ(振幅)

つまり、「いつ(横軸)、どんな高さの音(縦軸)が、どれくらいの強さで(色)鳴ったか」を一枚の絵にしたものがスペクトログラムです。この変換には、短時間フーリエ変換(STFT: Short-Time Fourier Transform) という数学的な手法が用いられます。

画像になった音を、CNNで診断する

音を画像に変換してしまえば、あとは私たちの得意分野です。画像認識で絶大な力を発揮するCNN(畳み込みニューラルネットワーク)の出番です。

CNNは、画像の中にある特徴的なパターン(線、角、模様など)を自動で学習する能力を持っています。例えば、猫の画像を大量に学習したCNNは、「とがった耳」や「ひげ」といった特徴を捉えるフィルターを内部に作り出します。

これと全く同じように、心音のスペクトログラムを大量に学習したAIは、

- 正常な心音のスペクトログラムに共通する「視覚的パターン」

- 収縮期駆出性雑音に特徴的な「ひし形の模様」

- 拡張期灌水様雑音に特徴的な「デクレッシェンド型の模様」

といった、「病的な音の見た目」を学習していきます。そして、未知の心音データが入力されたとき、そのスペクグラムがどちらのパターンに近いかを分類することで、診断の支援を行うのです。

臨床応用への道:スマートフォンが聴診器になる未来

この技術は、私たちの臨床に大きな変革をもたらす可能性を秘めています。

- 心雑音・不整脈のスクリーニング: プライマリ・ケアや学校検診の場で、デジタル聴診器が捉えた音をAIがリアルタイムに解析。「心雑音の疑いあり。循環器専門医へのコンサルトを推奨します」といったアラートを出すことで、専門医へのアクセスが困難な地域でも、早期発見の機会を増やすことができるかもしれません。

- 呼吸器疾患の診断支援とモニタリング: スマートフォンのマイクで患者さんの咳や呼吸音を録音してもらい、AIがその音響的特徴を解析。その咳が乾性か湿性か、あるいは喘息発作時の喘鳴(Wheezing)が含まれていないかを客観的に評価し、遠隔診療や在宅での状態管理に役立てることが期待されます。

- 嚥下機能の評価: 食事中の嚥下音を解析し、誤嚥のリスクを評価するといった、これまで熟練した専門家でなければ難しかった評価を、より簡便に行うための研究も進んでいます。

このように、音響解析AIは、物理的な聴診器というツールそのものを進化させると同時に、スマートフォンなどを通じて、医療を病院の外へと拡張していく力を持っているのです。

7.4 ウェアラブルデバイスと連携した連続的バイタルサインモニタリング

さて、これまで見てきた時系列解析、異常検知、そして音響解析といった個別のAI技術が、一つの大きな流れに合流する場所、それがこのウェアラブルデバイスとの連携です。これまでの技術が、いわばAIに搭載する個別の「能力」だとすれば、このセクションは、その能力をどのように「実社会」で活用するのか、という集大成的なトピックと言えるでしょう。

Apple Watchのようなスマートウォッチ、指輪型の活動量計、あるいは胸部に貼り付けるパッチ型心電計。これらのデバイスは、もはや単なるガジェットではありません。それは、「医療機関」という場所の制約から解放された、24時間稼働のバイタルサイン測定器なのです。

「宝の山」と、その挑戦

これらのデバイスは、日常生活のあらゆる場面で、心拍数、心拍変動、血中酸素飽和度、皮膚温、活動量、睡眠パターンといった、かつては入院しなければ得られなかったようなデータを、絶え間なく収集し続けます。このデータは、間違いなく「宝の山」です。しかし、同時にそれは、そのままでは活用が難しい、ノイズまみれの「データの奔流」でもあります。

| ウェアラブルデータの挑戦 | AIによる解決策 |

|---|---|

| 膨大なデータ量 | 人間がすべてを確認するのは不可能。AIによる自動的なデータ処理とフィルタリングが必須。 |

| ノイズとアーチファクト | 体動によるノイズやセンサーの接触不良など、信頼性の低いデータが混在。AIによる信号のクレンジングとノイズ除去技術が重要に。 |

| 文脈の欠如 | 心拍数が120bpmでも、運動中なのか安静時の不整脈なのかが不明。加速度センサーなど他の情報と組み合わせる「センサーフュージョン」で文脈を推定。 |

| データの欠損 | 充電中や装着忘れによるデータ欠損。AIによる統計的な補完(Imputation)や、欠損を考慮した解析モデルが必要。 |

これらの挑戦を乗り越え、データの奔流から真に価値ある情報を抽出するために、本日のレッスンで学んだAI技術が総動員されます。

【ウェアラブルデバイスにおけるAI解析パイプラインの全体像】

臨床応用:医療が「日常」に溶け込む未来

このパイプラインが実現する未来は、私たちの医療のあり方を根底から変える可能性を秘めています。

- 究極の予防医療へ: 例えば、睡眠中の心拍変動と呼吸パターンをAIが継続的に解析し、自律神経の不調や睡眠時無呼吸症候群のリスクを、本人が自覚症状を訴えるずっと前に警告する。あるいは、日中の心電図データから心房細動の兆候を検出し、「念のため、一度医療機関を受診してください」とスマートフォンに通知が届く。これはもうSFではなく、一部は既に実用化されている現実です。個人の健康管理が、「自分ごと」として、より主体的に行われるようになります。

- 慢性疾患管理のパーソナライズ: 例えば、一人暮らしの高齢の心不全患者さんがいるとします。在宅で体重、活動量、睡眠中の呼吸数などがウェアラブルデバイスで自動的に記録され、AIがその多次元データを統合的に解析。「体重が2日間で1kg増加し、夜間の呼吸数も増えている。これは体液貯留による心不全増悪の初期兆候かもしれない」と判断し、かかりつけ医や訪問看護師にアラートを送る。このような介入により、救急搬送や入院を未然に防ぎ、患者さんのQOLを維持することが可能になるかもしれません。

これらが示すのは、医療が「病気になってから治す」というリアクティブ(事後対応型)なものから、「病気になる前に介入し、重症化を防ぐ」というプロアクティブ(先制的)なものへと、その姿を大きく変えていく未来です。

さらには、集団の平均値に基づく医療から、たった一人のデータ(N-of-1)に基づいて、その人だけの正常・異常パターンを学習し、超個別化された介入を行う「ハイパー・パーソナライズド医療」への道も拓かれます。

もちろん、データのプライバシー、セキュリティ、規制、そして誰もが技術の恩恵を受けられるようにするためのデジタルデバイドの解消など、乗り越えるべき課題は山積みです。しかし、絶え間なく流れ込む生体データと、それを賢く解釈するAIとの融合が、医療を病院の壁の中から、私たちの日常生活の中へと解き放っていく。その大きな可能性を感じていただけたなら、これほど嬉しいことはありません。

まとめ:医療者の五感を拡張するAI

今回は、時間とともに変化する生体信号や音響データに、AIがどのように向き合うか、その概要をご紹介しました。

- 時系列解析: RNNやTransformerといったモデルで「時間の流れ」を読み解く。

- 異常検知: 心電図や脳波の膨大なデータから、稀な異常パターンを自動で検出する。

- 音響解析: 心音や呼吸音を「画像」に変換し、CNNで診断のヒントを得る。

- 連続モニタリング: ウェアラブルデバイスからのデータを活用し、予防医療や在宅管理に応用する。

これらの技術は、決して私たちの聴診器や臨床判断に取って代わるものではありません。むしろ、人間の能力には限界がある「24時間の連続監視」や「微細なパターンの定量化」といった領域をAIに任せることで、私たちの五感を拡張し、より質の高い医療判断を可能にする強力なパートナーとなるでしょう。

今後の記事では、これらの各トピックについて、より深い理論と実践的なプログラミングに踏み込んでいきます。

【注意事項】

本記事で紹介するAIツールは、診断・治療の意思決定を行うものではなく、情報整理やコミュニケーション支援を目的としたツールです。実際の医療行為には必ず医師の判断が必要であり、法令(医師法・薬機法・個人情報保護法等)を遵守する必要があります。

参考文献

- Hochreiter S, Schmidhuber J. Long short-term memory. Neural Comput. 1997;9(8):1735-80.

- Vaswani A, Shazeer N, Parmar N, Uszkoreit J, Jones L, Gomez AN, et al. Attention is all you need. In: Advances in Neural Information Processing Systems 30. Curran Associates, Inc.; 2017. p. 5998-6008.

- Hannun AY, Rajpurkar P, Haghpanahi M, Tison GH, Bourn C, Turakhia MP, et al. Cardiologist-level arrhythmia detection and classification in ambulatory ECGs using a deep neural network. Nat Med. 2019 Jan;25(1):65-69.

- Roy Y, Banville H, Albuquerque I, Gramfort A, Falk TH, Faubert J. Deep learning-based electroencephalography analysis: a systematic review. J Neural Eng. 2019 Oct;16(5):051001.

- Chandola V, Banerjee A, Kumar V. Anomaly detection: A survey. ACM Comput Surv. 2009 Jul;41(3):Article 15.

- Potes C, Parvaneh S, Rahman A, Conroy B, O’Connor T. Wearable inertial sensors for human movement analysis: a review. IEEE Sens J. 2016;16(22):7940-51.

- Clifford GD, Liu C, Moody B, Lehman LH, Silva I, Li Q, et al. AF Classification from a Short Single Lead ECG Recording: The PhysioNet/Computing in Cardiology Challenge 2017. In: 2017 Computing in Cardiology (CinC). Rennes, France; 2017. p. 1-4.

- Alqudaihi K, Zghaib R, Al-subari K, El-Samie FEA, Al-Megren S, Iliyasu AM, et al. A review of AI-based analysis of heart sounds and its application in clinical diagnosis. Comput Methods Programs Biomed. 2021 May;204:106060.

- Pahar M, Klopper M, Warren R, Niesler T. A review of deep learning based methods for cough detection. J-BHI. 2021;25(10):3745-3756.

- Islam SMR, Kwak D, Kabir MH, Hossain M, Kwak K. The Internet of Things for Health Care: A Comprehensive Survey. IEEE Access. 2015;3:678-708.

- Majumder S, Deen MJ. Smartphone Sensors for Health Monitoring and Diagnosis. Sensors (Basel). 2019 May 15;19(10):2252.

- Topol EJ. High-performance medicine: the convergence of human and artificial intelligence. Nat Med. 2019 Jan;25(1):44-56.

ご利用規約(免責事項)

当サイト(以下「本サイト」といいます)をご利用になる前に、本ご利用規約(以下「本規約」といいます)をよくお読みください。本サイトを利用された時点で、利用者は本規約の全ての条項に同意したものとみなします。

第1条(目的と情報の性質)

- 本サイトは、医療分野におけるAI技術に関する一般的な情報提供および技術的な学習機会の提供を唯一の目的とします。

- 本サイトで提供されるすべてのコンテンツ(文章、図表、コード、データセットの紹介等を含みますが、これらに限定されません)は、一般的な学習参考用であり、いかなる場合も医学的な助言、診断、治療、またはこれらに準ずる行為(以下「医行為等」といいます)を提供するものではありません。

- 本サイトのコンテンツは、特定の製品、技術、または治療法の有効性、安全性を保証、推奨、または広告・販売促進するものではありません。紹介する技術には研究開発段階のものが含まれており、その臨床応用には、さらなる研究と国内外の規制当局による正式な承認が別途必要です。

- 本サイトは、情報提供を目的としたものであり、特定の治療法を推奨するものではありません。健康に関するご懸念やご相談は、必ず専門の医療機関にご相談ください。

第2条(法令等の遵守)

利用者は、本サイトの利用にあたり、医師法、医薬品、医療機器等の品質、有効性及び安全性の確保等に関する法律(薬機法)、個人情報の保護に関する法律、医療法、医療広告ガイドライン、その他関連する国内外の全ての法令、条例、規則、および各省庁・学会等が定める最新のガイドライン等を、自らの責任において遵守するものとします。これらの適用判断についても、利用者が自ら関係各所に確認するものとし、本サイトは一切の責任を負いません。

第3条(医療行為における責任)

- 本サイトで紹介するAI技術・手法は、あくまで研究段階の技術的解説であり、実際の臨床現場での診断・治療を代替、補助、または推奨するものでは一切ありません。

- 医行為等に関する最終的な判断、決定、およびそれに伴う一切の責任は、必ず法律上その資格を認められた医療専門家(医師、歯科医師等)が負うものとします。AIによる出力を、資格を有する専門家による独立した検証および判断を経ずに利用することを固く禁じます。

- 本サイトの情報に基づくいかなる行為によって利用者または第三者に損害が生じた場合も、本サイト運営者は一切の責任を負いません。実際の臨床判断に際しては、必ず担当の医療専門家にご相談ください。本サイトの利用によって、利用者と本サイト運営者の間に、医師と患者の関係、またはその他いかなる専門的な関係も成立するものではありません。

第4条(情報の正確性・完全性・有用性)

- 本サイトは、掲載する情報(数値、事例、ソースコード、ライブラリのバージョン等)の正確性、完全性、網羅性、有用性、特定目的への適合性、その他一切の事項について、何ら保証するものではありません。

- 掲載情報は執筆時点のものであり、予告なく変更または削除されることがあります。また、技術の進展、ライブラリの更新等により、情報は古くなる可能性があります。利用者は、必ず自身で公式ドキュメント等の最新情報を確認し、自らの責任で情報を利用するものとします。

第5条(AI生成コンテンツに関する注意事項)

本サイトのコンテンツには、AIによる提案を基に作成された部分が含まれる場合がありますが、公開にあたっては人間による監修・編集を経ています。利用者が生成AI等を用いる際は、ハルシネーション(事実に基づかない情報の生成)やバイアスのリスクが内在することを十分に理解し、その出力を鵜呑みにすることなく、必ず専門家による検証を行うものとします。

第6条(知的財産権)

- 本サイトを構成するすべてのコンテンツに関する著作権、商標権、その他一切の知的財産権は、本サイト運営者または正当な権利を有する第三者に帰属します。

- 本サイトのコンテンツを引用、転載、複製、改変、その他の二次利用を行う場合は、著作権法その他関連法規を遵守し、必ず出典を明記するとともに、権利者の許諾を得るなど、適切な手続きを自らの責任で行うものとします。

第7条(プライバシー・倫理)

本サイトで紹介または言及されるデータセット等を利用する場合、利用者は当該データセットに付随するライセンス条件および研究倫理指針を厳格に遵守し、個人情報の匿名化や同意取得の確認など、適用される法規制に基づき必要とされるすべての措置を、自らの責任において講じるものとします。

第8条(利用環境)

本サイトで紹介するソースコードやライブラリは、執筆時点で特定のバージョンおよび実行環境(OS、ハードウェア、依存パッケージ等)を前提としています。利用者の環境における動作を保証するものではなく、互換性の問題等に起因するいかなる不利益・損害についても、本サイト運営者は責任を負いません。

第9条(免責事項)

- 本サイト運営者は、利用者が本サイトを利用したこと、または利用できなかったことによって生じる一切の損害(直接損害、間接損害、付随的損害、特別損害、懲罰的損害、逸失利益、データの消失、プログラムの毀損等を含みますが、これらに限定されません)について、その原因の如何を問わず、一切の法的責任を負わないものとします。

- 本サイトの利用は、学習および研究目的に限定されるものとし、それ以外の目的での利用はご遠慮ください。

- 本サイトの利用に関連して、利用者と第三者との間で紛争が生じた場合、利用者は自らの費用と責任においてこれを解決するものとし、本サイト運営者に一切の迷惑または損害を与えないものとします。

- 本サイト運営者は、いつでも予告なく本サイトの運営を中断、中止、または内容を変更できるものとし、これによって利用者に生じたいかなる損害についても責任を負いません。

第10条(規約の変更)

本サイト運営者は、必要と判断した場合、利用者の承諾を得ることなく、いつでも本規約を変更することができます。変更後の規約は、本サイト上に掲載された時点で効力を生じるものとし、利用者は変更後の規約に拘束されるものとします。

第11条(準拠法および合意管轄)

本規約の解釈にあたっては、日本法を準拠法とします。本サイトの利用および本規約に関連して生じる一切の紛争については、東京地方裁判所を第一審の専属的合意管轄裁判所とします。

For J³, may joy follow you.