医療AIの真価を引き出す医師の覚醒

なぜ、私たちは「中身」を知る必要があるのか?

少し想像してみてください。

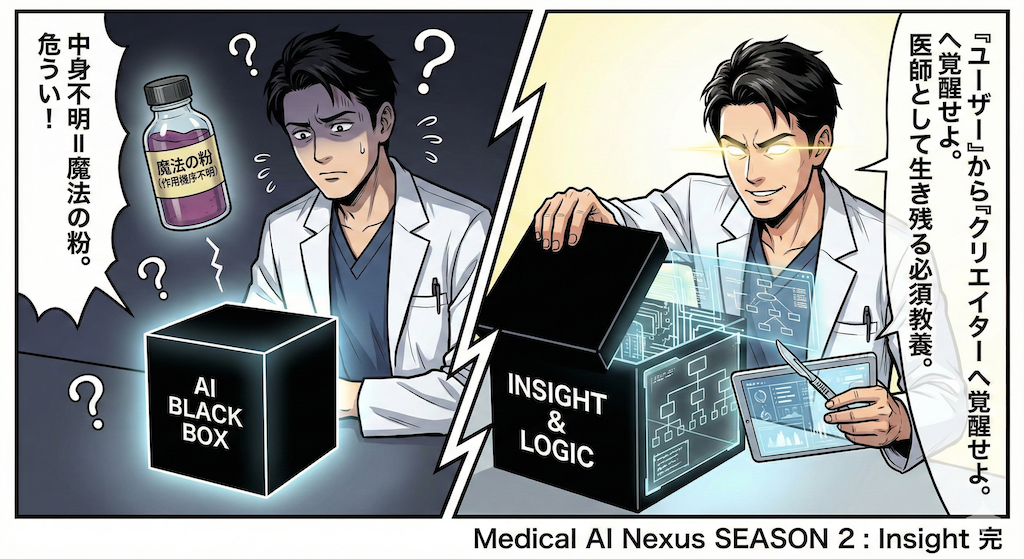

もし、製薬会社から「この新薬は『魔法の粉』です。作用機序(MOA)は不明ですが、とにかく効くので患者さんに投与してください」と言われたら、どう感じるでしょうか?

「そんな恐ろしいもの、使えるわけがない!」と即答するはずです。私たちは、なぜその薬が効くのか、どのような副作用リスクがあるのか、その「理屈(ロジック)」を知っているからこそ、責任を持ってメスを握り、処方箋を書くことができます。

しかし、AIとなるとどうでしょう?

「このツールに入力すれば、AIが良い感じに診断してくれます」という言葉を信じて、中身がブラックボックスのまま使ってしまう……。実はこれ、先ほどの「魔法の粉」と同じくらい危ういことではないでしょうか?

Medical AI Nexusの「SEASON 2: Insight」の締めくくりとなる今回は、AIという名のブラックボックスをこじ開け、単なる「ユーザー」から、医療AIを正しく評価し、時には自ら作り出す「クリエイター(創造する側)」へと覚醒するためのマインドセットについてお話しします。

これは、プログラマーへの転職勧誘ではありません。これからの時代に「医療に関わる者として生き残る」ための、必須の教養のお話です。

1. 「ブラックボックス」の正体と、臨床現場のリスク

そもそも、AI(特にディープラーニング)における「ブラックボックス」とは何を指すのでしょうか?

従来の手続き型プログラミング(ルールベース)では、「熱が38度以上なら解熱剤を投与する」というように、人間が書いた明確な If-Then ルールが存在し、そのロジックは誰の目にも明らかでした。

しかし、現代のAIは根本的に異なります。AIは大量のデータから勝手に特徴を見つけ出し、人間には直感的に理解不能なほど複雑な数式(膨大なパラメータの塊)として学習します(Rudin, 2019)。入力データが投げ込まれてから、結果が出力されるまでの間にある、この「計算プロセスが人間に見えない状態」こそが、ブラックボックスの正体です。

臨床現場に潜む「オートメーション・バイアス」の罠

なぜこれが医療において重大な問題となるのでしょうか。それは、AIが提示した結果を、医師が無批判に受け入れてしまう「オートメーション・バイアス」のリスクがあるからです。

AIは時に、もっともらしい顔をして自信満々に嘘をつきます(ハルシネーション)。また、学習データの偏りをそのまま反映し、差別的な判断を下すこともあります。

例えば、以前の回でも紹介した、米国の医療現場で実際に起きた衝撃的な事例があります。あるアルゴリズムが、医学的には同じような重症度であっても、黒人患者より白人患者の方を「リスクが高い(より手厚いケアが必要)」と判定していました。

この原因は、AIが「過去の医療費」を重症度の代理指標として学習していたことにありました。当時の社会背景として、黒人層は医療アクセスが悪く、結果として医療費が低くなる傾向がありました。AIは悪気なく、そのデータの相関関係を忠実に学習し、「医療費が低い=重症度が低い」と誤って判断してしまったのです(Obermeyer et al., 2019)。

もし医師がアルゴリズムの「中身(何を指標にしているか)」に関心を持たず、AIのスコアを鵜呑みにしていたらどうなっていたでしょうか。不公平な医療格差を、テクノロジーの力でさらに拡大再生産することになってしまいます。

私たちは、機械が出した答えに対して「なぜ?」と問いかける説明可能性(Explainability / XAI)への感度を、常に研ぎ澄ませておく必要があります(Tjoa & Guan, 2021)。

2. ノーコードの限界と、「コードを書く」意義

最近では、プログラミングができなくてもマウス操作だけでAIモデルを作れる「ノーコードツール」が流行しています。

これを見て、「じゃあ、苦労してコードなんて書かなくていいじゃないか」と思われるかもしれません。確かに、一理あります。

ここで、少し料理に例えて考えてみましょう。

ノーコードツールは、いわば「高級レストランのミールキット」のようなものです。パッケージされた食材を使い、決められた手順通りに作れば、誰でも失敗なく、一定レベル以上の美味しい料理が作れます。これは素晴らしいことです。

しかし、「塩分を極力控えたい」「特定の食材アレルギーに対応してほしい」「隠し味に地元のスパイスを入れたい」といった、個別具体的な要望(カスタマイズ)には、パッケージ製品では対応できません。

一方、コードを書くことは、「市場で食材から選んで、包丁で刻んで調理する」ことです。

実際の臨床現場にあるデータは、教科書のように整理整頓された綺麗なものではありません。欠損値だらけの電子カルテ、メーカーごとに仕様が異なる画像フォーマット、その施設特有のローカルな入力ルール……。これら「現場の泥臭いリアル」に対応し、前処理を行うには、既製品のツールの機能だけでは太刀打ちできないのです。

自らPythonという言語を操り、コードを書くこと。

それは、汎用品を当てはめるのではなく、「自分の施設、目の前の患者さんに最適化されたAI」を仕立て上げるための、唯一にして最強の手段と言えます(Topol, 2019)。

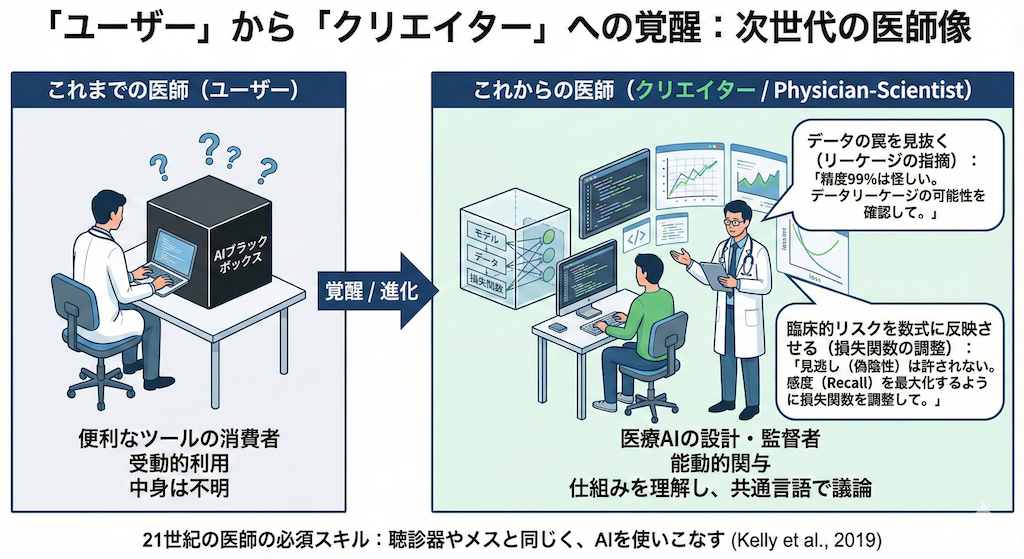

3. 「ユーザー」から「クリエイター」への覚醒

これからの医療AI教育が目指すゴールは、決して「全ての医師をプロのエンジニアにすること」ではありません。餅は餅屋です。コードの最適化はプロに任せれば良いのです。

私たちが目指すのは、エンジニアの言語を理解し、彼らと対等に議論ができる「Physician-Scientist(科学的視点を持つ医師)」を育てることにあります。

AIの仕組み(中身)を知っている医師は、ブラックボックスを前にしても怯まず、エンジニアに対して以下のような「臨床的価値に基づいた的確な指示」が出せるようになります。

- データの罠を見抜く(リーケージの指摘)

「このモデルの精度99%は怪しすぎる。臨床現場のデータはもっとノイズが多いはずだ。診断結果が予期せず混入しているなど、臨床的にあり得ない特徴量を見てしまっている(データリーケージ)可能性が高いから、確認してほしい」 - 臨床的リスクを数式に反映させる(損失関数の調整)

「今の損失関数の設定では、偽陰性(見逃し)を許容しすぎている。この疾患は進行が早く、見逃しが患者の生命に関わる。偽陽性(空振り)が増えても構わないから、感度(Recall)を最大化するようにモデルを再調整してくれ」

このレベルの会話ができた時、あなたは単なる「便利なツールの消費者(ユーザー)」を卒業し、医療AIという新たな医療機器を設計・監督する「創造者(クリエイター)」へと進化します。

これは、かつての医師が聴診器やメスの使い方を学んだのと全く同列の、21世紀の医師が持つべき必須のスキルなのです(Kelly et al., 2019)。

さあ、自分の手で命を吹き込もう

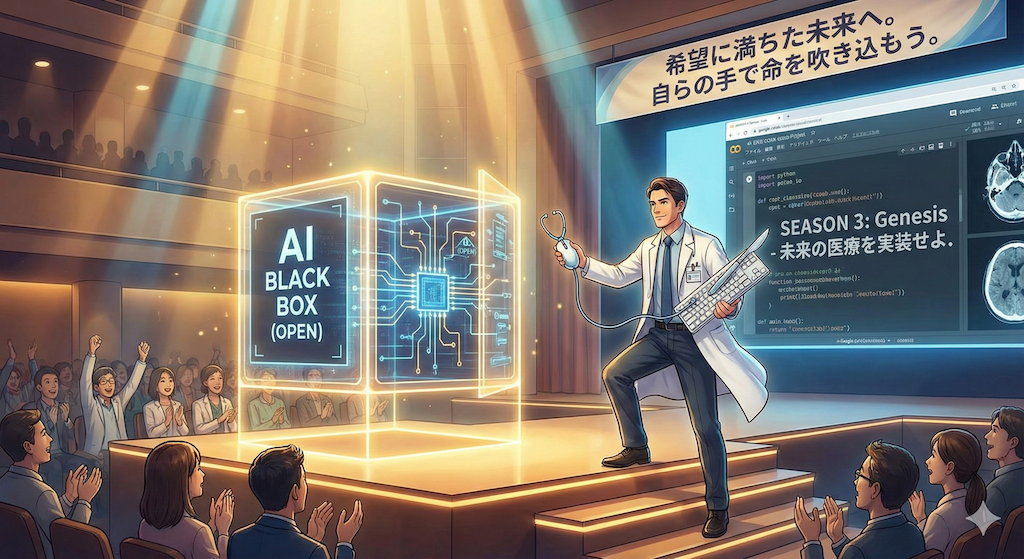

ここまで、SEASON 2を通じて、AIの「中身(アルゴリズムや数学的背景)」を直感的に覗き込んできました。

かつては分厚い鉄の扉に見えたブラックボックスの蓋は、もう開きかけています。

次なる [SEASON 3: Genesis] では、いよいよ観客席から立ち上がり、ステージの上へと上がっていただきます。

実際にブラウザ上で「Google Colab」という開発環境を開き、Pythonコードを一行ずつ打ち込み、ご自身の手でゼロからAIモデルを構築します。

「プログラミングなんて、自分にできるだろうか?」と不安に思うかもしれません。

しかし、大丈夫です。膨大な解剖学の名称や複雑な生理学を理解し、過酷な試験を乗り越えてきた医師・医療従事者の方はもちろんのこと、日々それぞれの専門分野で複雑な課題に向き合い、新しい知識を学び続けている皆さんなら、AIの仕組みなど恐るるに足りません。

論理的思考力と学習能力において、挑戦を続ける皆さんはすでにトップアスリートなのですから。

自らコードを書き、エンターキー(実行ボタン)を押したその瞬間、画面の向こうでAIがデータを飲み込み、学習を始め、やがて未知のデータに対して答えを出し始める——。

その「無機質なプログラムに知能が宿り、立ち上がる瞬間」の感動は、何物にも代えがたい知的興奮となるはずです。

準備はいいですか?

聴診器をマウスに、メスをキーボードに持ち替えて。さあ、未来の医療をその手で実装しにいきましょう。

参考文献

- Rudin, C. (2019). Stop explaining black box machine learning models for high stakes decisions and use interpretable models instead. Nature Machine Intelligence, 1(5), 206–215.

- Obermeyer, Z., Powers, B., Vogeli, C. and Mullainathan, S. (2019). Dissecting racial bias in an algorithm used to manage the health of populations. Science, 366(6464), 447–453.

- Topol, E.J. (2019). High-performance medicine: the convergence of human and artificial intelligence. Nature Medicine, 25(1), 44–56.

- Kelly, C.J., Karthikesalingam, A., Suleyman, M., Corrado, G. and King, D. (2019). Key challenges for delivering clinical impact with artificial intelligence. BMC Medicine, 17(1), 195.

- Tjoa, E. and Guan, C. (2021). A Survey on Explainable Artificial Intelligence (XAI): Toward Medical XAI. IEEE Transactions on Neural Networks and Learning Systems, 32(11), 4793–4813.

※本記事は情報提供を目的としたものであり、特定の治療法を推奨するものではありません。健康に関するご懸念やご相談は、必ず専門の医療機関にご相談ください。

ご利用規約(免責事項)

当サイト(以下「本サイト」といいます)をご利用になる前に、本ご利用規約(以下「本規約」といいます)をよくお読みください。本サイトを利用された時点で、利用者は本規約の全ての条項に同意したものとみなします。

第1条(目的と情報の性質)

- 本サイトは、医療分野におけるAI技術に関する一般的な情報提供および技術的な学習機会の提供を唯一の目的とします。

- 本サイトで提供されるすべてのコンテンツ(文章、図表、コード、データセットの紹介等を含みますが、これらに限定されません)は、一般的な学習参考用であり、いかなる場合も医学的な助言、診断、治療、またはこれらに準ずる行為(以下「医行為等」といいます)を提供するものではありません。

- 本サイトのコンテンツは、特定の製品、技術、または治療法の有効性、安全性を保証、推奨、または広告・販売促進するものではありません。紹介する技術には研究開発段階のものが含まれており、その臨床応用には、さらなる研究と国内外の規制当局による正式な承認が別途必要です。

- 本サイトは、情報提供を目的としたものであり、特定の治療法を推奨するものではありません。健康に関するご懸念やご相談は、必ず専門の医療機関にご相談ください。

第2条(法令等の遵守)

利用者は、本サイトの利用にあたり、医師法、医薬品、医療機器等の品質、有効性及び安全性の確保等に関する法律(薬機法)、個人情報の保護に関する法律、医療法、医療広告ガイドライン、その他関連する国内外の全ての法令、条例、規則、および各省庁・学会等が定める最新のガイドライン等を、自らの責任において遵守するものとします。これらの適用判断についても、利用者が自ら関係各所に確認するものとし、本サイトは一切の責任を負いません。

第3条(医療行為における責任)

- 本サイトで紹介するAI技術・手法は、あくまで研究段階の技術的解説であり、実際の臨床現場での診断・治療を代替、補助、または推奨するものでは一切ありません。

- 医行為等に関する最終的な判断、決定、およびそれに伴う一切の責任は、必ず法律上その資格を認められた医療専門家(医師、歯科医師等)が負うものとします。AIによる出力を、資格を有する専門家による独立した検証および判断を経ずに利用することを固く禁じます。

- 本サイトの情報に基づくいかなる行為によって利用者または第三者に損害が生じた場合も、本サイト運営者は一切の責任を負いません。実際の臨床判断に際しては、必ず担当の医療専門家にご相談ください。本サイトの利用によって、利用者と本サイト運営者の間に、医師と患者の関係、またはその他いかなる専門的な関係も成立するものではありません。

第4条(情報の正確性・完全性・有用性)

- 本サイトは、掲載する情報(数値、事例、ソースコード、ライブラリのバージョン等)の正確性、完全性、網羅性、有用性、特定目的への適合性、その他一切の事項について、何ら保証するものではありません。

- 掲載情報は執筆時点のものであり、予告なく変更または削除されることがあります。また、技術の進展、ライブラリの更新等により、情報は古くなる可能性があります。利用者は、必ず自身で公式ドキュメント等の最新情報を確認し、自らの責任で情報を利用するものとします。

第5条(AI生成コンテンツに関する注意事項)

本サイトのコンテンツには、AIによる提案を基に作成された部分が含まれる場合がありますが、公開にあたっては人間による監修・編集を経ています。利用者が生成AI等を用いる際は、ハルシネーション(事実に基づかない情報の生成)やバイアスのリスクが内在することを十分に理解し、その出力を鵜呑みにすることなく、必ず専門家による検証を行うものとします。

第6条(知的財産権)

- 本サイトを構成するすべてのコンテンツに関する著作権、商標権、その他一切の知的財産権は、本サイト運営者または正当な権利を有する第三者に帰属します。

- 本サイトのコンテンツを引用、転載、複製、改変、その他の二次利用を行う場合は、著作権法その他関連法規を遵守し、必ず出典を明記するとともに、権利者の許諾を得るなど、適切な手続きを自らの責任で行うものとします。

第7条(プライバシー・倫理)

本サイトで紹介または言及されるデータセット等を利用する場合、利用者は当該データセットに付随するライセンス条件および研究倫理指針を厳格に遵守し、個人情報の匿名化や同意取得の確認など、適用される法規制に基づき必要とされるすべての措置を、自らの責任において講じるものとします。

第8条(利用環境)

本サイトで紹介するソースコードやライブラリは、執筆時点で特定のバージョンおよび実行環境(OS、ハードウェア、依存パッケージ等)を前提としています。利用者の環境における動作を保証するものではなく、互換性の問題等に起因するいかなる不利益・損害についても、本サイト運営者は責任を負いません。

第9条(免責事項)

- 本サイト運営者は、利用者が本サイトを利用したこと、または利用できなかったことによって生じる一切の損害(直接損害、間接損害、付随的損害、特別損害、懲罰的損害、逸失利益、データの消失、プログラムの毀損等を含みますが、これらに限定されません)について、その原因の如何を問わず、一切の法的責任を負わないものとします。

- 本サイトの利用は、学習および研究目的に限定されるものとし、それ以外の目的での利用はご遠慮ください。

- 本サイトの利用に関連して、利用者と第三者との間で紛争が生じた場合、利用者は自らの費用と責任においてこれを解決するものとし、本サイト運営者に一切の迷惑または損害を与えないものとします。

- 本サイト運営者は、いつでも予告なく本サイトの運営を中断、中止、または内容を変更できるものとし、これによって利用者に生じたいかなる損害についても責任を負いません。

第10条(規約の変更)

本サイト運営者は、必要と判断した場合、利用者の承諾を得ることなく、いつでも本規約を変更することができます。変更後の規約は、本サイト上に掲載された時点で効力を生じるものとし、利用者は変更後の規約に拘束されるものとします。

第11条(準拠法および合意管轄)

本規約の解釈にあたっては、日本法を準拠法とします。本サイトの利用および本規約に関連して生じる一切の紛争については、東京地方裁判所を第一審の専属的合意管轄裁判所とします。

For J³, may joy follow you.