TL; DR (要約)

希少疾患研究の「データがない!」という壁を、AI自身の力で乗り越える技術、それがデータ拡張です。

データを「水増し」する古典的な手法から、ゼロから「創造」する最先端の生成AIまで、その光と影をまとめました。

① 伝統的な拡張

(見た目の水増し)

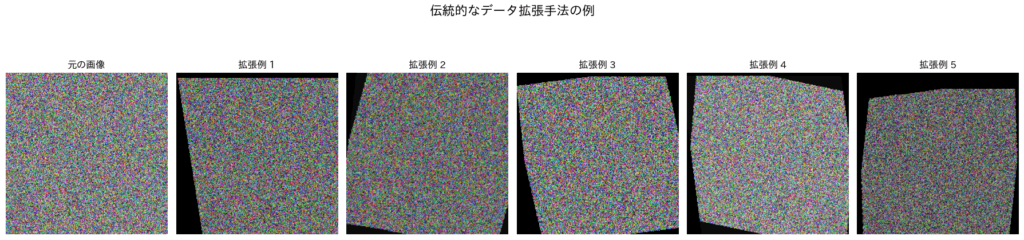

画像を回転・反転させ、AIに多様な見せ方を教える古典的な手法。手軽で有効ですが、元データの限界は超えられません。

② 生成AIによる拡張

(データの創造)

拡散モデルが、本物そっくりの合成医用画像をゼロから「創造」。データ不足を根本から解決する可能性を秘めます。

③ 倫理的な課題

(バイアスの増幅)

【注意】元データに潜む偏見(バイアス)を、AIがさらに増幅させてしまう危険性も。公平性の検証が不可欠です。

| この章の学習目標 | 1. データ拡張の重要性: なぜAI開発、特に希少疾患研究においてデータ拡張が不可欠なのかを理解する。 2. 伝統的な手法と限界: 画像の回転や反転といった、古典的なデータ拡張手法の原理とその限界を学ぶ。 3. 生成AIによるデータ拡張: 拡散モデル(Diffusion Models)が、いかにして高品質で多様な合成医用画像を生成するか、その基本概念を掴む。 4. 倫理的課題: 合成データを利用する際のバイアス増幅リスクと、その対策の重要性を認識する。 |

| 前提となる知識 | ・AI、機械学習、深層学習に関する基本的な概念の理解 ・(推奨)医用画像(CT, MRIなど)の基本的な特性に関する知識 |

はじめに:希少疾患研究における「数の壁」

私たち臨床医が、その長いキャリアの中で一度も出会うことがないかもしれない、一つの希少疾患。しかし、視点を世界に広げれば、その数は決して少なくありません。世界全体で見れば3億人以上、20人に1人が何らかの希少疾患に罹患しているとも言われています[1]。

その診断や治療法開発は、極めて重要でありながら、常に一つの大きな壁に直面してきました。それは、圧倒的な「データ不足」という壁です。

質の高いAIモデルを開発するには、通常、何千、何万という大量のデータが必要です。しかし、患者数が極端に少ない希少疾患では、そのような大規模なデータセットを構築することは、ほとんど不可能です。私自身、研究の現場で「対象となる症例がn=5しかないので、統計的な解析は困難です」という結論に、悔しい思いをした経験が何度もあります。研究を進めたくても、そもそも材料がない——。この「鶏が先か、卵が先か」にも似たジレンマは、長年、希少疾患研究の進展を阻む大きな要因となってきました。

もし、この「数の壁」を、AI自身の力を使って乗り越えることができるとしたら、どうでしょう。もし、たった数十例の貴重なデータに宿る「疾患の本質」をAIが深く学び取り、数千例分にも匹敵する、リアルで多様な「仮想の患者データ」を生成できるとしたら、私たちの研究はどこまで加速するでしょうか。

本講座「作って理解する!シリーズ医療×生成系AI」の第11回は、この「データがない」という根源的な課題に、データ拡張(Data Augmentation)という技術で挑みます。既存のデータを「水増し」する古典的な手法から、生成AIを用いて全く新しいデータを「創造」する最先端の技術まで、希少疾患研究のブレークスルーを可能にするアプローチを見ていきましょう。

この記事では、第11回で学ぶ4つの主要なトピックの全体像を、いわば旅の地図としてダイジェストでご紹介します。なお、本記事は各トピックの概要を掴んでいただくためのサマリーです。拡散モデルの数理的背景や、具体的なプログラミング実装、そして合成データを利用する上で避けては通れない倫理的課題への技術的対策については、11.1以降の個別記事で丁寧に解説していきますので、ご安心ください。

11.1 医療データ拡張の重要性と伝統的な手法

AIモデル、特に深層学習モデルは、非常に優秀ですが、時に「真面目すぎる学生」に似ています。もし、ほんの数枚の練習問題(データ)しか与えられないと、その問題の解き方を「丸暗記」してしまいます。これを過学習(Overfitting)と呼びます。この状態のモデルは、一度見た問題は100点で解けますが、少しでも形式が違う応用問題(未知のデータ)が出されると、全く手が出なくなってしまうのです。

AIが真に賢くなる、すなわち様々な状況に対応できる汎化性能(Generalization)を獲得するためには、多様で豊富な練習問題をたくさん解かせる必要があります。この「練習問題を人為的に増やす」技術こそが、データ拡張(Data Augmentation)です。

直感的なイメージ:AIに多様性を教える

子供に「猫」という動物を教える時、同じ方向を向いた一枚の写真だけを見せ続けることはしないでしょう。横向きの写真、逆光の写真、少し傾いた写真、丸まっている写真など、色々なバリエーションを見せるはずです。これにより、子供は猫という存在の本質的な特徴を学び、どんな状況でも猫を「猫」として認識できるようになります。

データ拡張は、これと全く同じことをAIに対して行うプロセスです。一枚の医用画像から、ありとあらゆる「ありそうな」バリエーションを擬似的に作り出し、AIに「これら全部が同じ疾患の画像だよ」と教え込むことで、モデルをより賢く、より頑健にしていくのです。

伝統的なデータ拡張手法:画像の「見た目」を変える

古典的で、今でも広く使われているのが、画像に対する幾何学的な変換や色調の変化です。これらは実装が容易でありながら、特に医用画像分類モデルの性能向上に非常に効果的であることが知られています[3]。

| カテゴリ | 手法 | 医療における意義 |

|---|---|---|

| 幾何学的変換 | 回転、左右反転、拡大・縮小、平行移動、せん断変形 | 患者さんの体位の微妙な違い、撮影角度のズレ、スキャナからの距離の違いなどを模倣し、AIモデルが位置や向きといった見た目の変化に惑わされないようにする。 |

| 色彩・強度変換 | 明るさ、コントラスト、彩度の変更 | 異なるメーカーのCT/MRI装置や、撮影プロトコルの違いによって生じる画像の明るさやコントラストの差をAIに学習させ、どのような撮影条件下でも安定した性能を発揮できるようにする。 |

| ノイズ・ぼかし | ガウシアンノイズの付加、モーションブラー | 撮影時に避けられない微小な電気的ノイズや、患者さんのわずかな動きによる画像のブレをシミュレートする。より現実世界のデータに近い状況で学習させることで、頑健性を高める。 |

ハンズオン:一枚の画像から「練習問題」を自動生成する

では、この「練習問題」をプログラムで自動生成する様子を実際に見てみましょう。ここでは、代表的な深層学習ライブラリであるPyTorchに含まれるtorchvisionを使って、一枚の画像から様々なバリエーションを生み出す様子を可視化します。

【実行前の準備】以下のコードは、画像のデータ拡張を可視化します。実行前に pip install torch torchvision matplotlib japanize-matplotlib を実行してください。(本コードで使用するPyTorch、torchvision、matplotlib、numpyは、それぞれBSD-style, PSF-styleの寛容なライセンスで提供されています。)

graph TD

A["開始"] --> B["1. 元画像を準備

(サンプルとしてダミー画像を1枚生成)"];

B --> C["2. データ拡張のルールを定義

(回転、反転、色調整などの処理を組み合わせる)"];

C --> D["3. 拡張画像を複数枚生成

(定義したルールを元画像に繰り返し適用)"];

D --> E["4. 結果を可視化

(元の画像と生成した拡張画像を並べて表示)"];

E --> F["終了"];

# 必要なライブラリをインポートします

import torch

import torchvision.transforms as T

from torchvision.datasets import FakeData # サンプル画像データを生成するための機能

import matplotlib.pyplot as plt

import japanize_matplotlib # 日本語表示を有効化

import numpy as np

# --- サンプル画像の準備 ---

# ここでは、実際の医用画像の代わりに、サンプルとしてダミーの画像データセットを使います

# size=224は画像のサイズ、num_classes=1はクラス数を指定します

dummy_dataset = FakeData(size=224, num_classes=1, transform=T.ToTensor())

# データセットから最初の画像を取り出します

original_image_tensor, _ = dummy_dataset[0]

# --- データ拡張の定義 ---

# torchvision.transformsを使って、一連の画像変換処理を定義します

# これら一連の処理が、AIモデルの学習中にリアルタイムで適用されます

data_augmentation_transform = T.Compose([

T.ToPILImage(), # テンソルを画像処理ライブラリPILの形式に変換(各種変換処理のため)

T.RandomRotation(degrees=15), # 画像を-15度から+15度の範囲でランダムに回転

T.RandomHorizontalFlip(p=0.5), # 50%の確率で画像を左右反転

T.ColorJitter(brightness=0.2, contrast=0.2, saturation=0.2), # 明るさ、コントラスト、彩度をランダムに変化

T.RandomAffine(degrees=0, translate=(0.1, 0.1), scale=(0.9, 1.1), shear=10), # 平行移動、拡大縮小、せん断変形をランダムに適用

T.ToTensor(), # 再び計算用のテンソル形式に戻す

])

# --- 拡張画像の生成と可視化 ---

# 描画エリアを準備します (1行6列のサブプロット)

fig, axes = plt.subplots(1, 6, figsize=(18, 5))

# 0番目のサブプロットに元の画像を表示します

axes[0].imshow(original_image_tensor.permute(1, 2, 0)) # (C, H, W)から(H, W, C)へ次元を並べ替え

axes[0].set_title('元の画像')

axes[0].axis('off') # 軸の目盛りを非表示に

# 5枚の拡張画像を生成して、1番目から5番目のサブプロットに表示します

for i in range(1, 6):

# 元の画像にデータ拡張処理を適用して、新しい画像を生成します

augmented_image_tensor = data_augmentation_transform(original_image_tensor)

# 拡張された画像をプロットします

axes[i].imshow(augmented_image_tensor.permute(1, 2, 0))

# 各拡張画像のタイトルを設定します

axes[i].set_title(f'拡張例 {i}')

# 軸の目盛りを非表示にします

axes[i].axis('off')

# グラフ全体のタイトルを設定します

fig.suptitle('伝統的なデータ拡張手法の例', fontsize=16)

# サブプロット間のレイアウトを自動で調整します

plt.tight_layout()

# グラフを画面に表示します

plt.show()

これらの手法は非常に有効ですが、お気づきの通り、あくまで「元の画像に存在する情報」の範囲内でしかバリエーションを増やせません。例えば、元データにない角度の病変や、全く新しいテクスチャを持つ症例を「創造」することは不可能です。

では、AIに、私たちのデータセットには存在しない、全く新しい症例画像をゼロから描かせることは可能なのでしょうか?その問いに答えるのが、次にご紹介する拡散モデルをはじめとした、生成AIの世界です。

11.2 拡散モデル(Diffusion Models)を用いた高品質な合成医用画像の生成

前のセクションで見た伝統的なデータ拡張は、いわば「一枚の写真の構図や色合いを変える」技術でした。非常に有効な一方で、その可能性は常に元画像の持つ情報に縛られてしまいます。

では、AI自身が、私たちが持つデータセットには存在しない、全く新しい症例画像をゼロから「創造」することはできないのでしょうか? 例えば、私たちがまだ見たことのないパターンの病変を持つ、リアルなCT画像を。

この問いに、近年のAI研究は「YES」という力強い答えを提示しました。その中核を担うのが、MidjourneyやStable Diffusionといった画像生成AIの心臓部でもある、拡散モデル(Diffusion Models)です[2]。

拡散モデルの哲学:秩序ある破壊と、そこからの創造

拡散モデルのアイデアは、非常にユニークで、どこか哲学的ですらあります。それは「一度、秩序を完全なカオス(無秩序)へと破壊し、その逆のプロセスを完全に学習することで、カオスから新たな秩序を創造する」という考え方に基づいています。

- 拡散過程(Forward Process): 秩序を破壊し、ノイズへ

まず、手元にある綺麗な医用画像(秩序)に、ごく僅かなノイズ(乱数)を少しずつ、何百、何千ステップにもわたって加えていきます。この過程を繰り返すと、画像は徐々にその意味を失い、最終的にはただのランダムなノイズ(完全なカオス)の画像になってしまいます。これは、インクを一滴ずつ水に落としていくと、最終的にインクが完全に拡散して見えなくなる様子に似ています。

概念を数式で表現すると、時刻\(t\)の画像 \(x_t\) は、一つ前の画像 \(x_{t-1}\) に、ある決まった量のノイズ \(\epsilon\) を加えることで生成されます。 \[ x_t = \sqrt{1 – \beta_t} x_{t-1} + \sqrt{\beta_t} \epsilon \quad (\text{ここで } \epsilon \sim \mathcal{N}(0, I)) \] 少し難しく見えるかもしれませんが、これは単に「前の画像を少し薄め(\(\sqrt{1 – \beta_t}\))、そこに新しいノイズ(\(\sqrt{\beta_t} \epsilon\))を混ぜる」という操作を表しているだけです。 - 逆拡散過程(Reverse Process): ノイズから秩序を再構築するAI

ここからがAIの出番です。AIモデル(多くはU-Netと呼ばれる構造のニューラルネットワーク)の仕事は、この拡散過程を完全に逆再生することです。

具体的には、あるノイズまみれの画像 \(x_t\) を見せられたAIは、「この画像が一つ前の、よりクリーンな画像 \(x_{t-1}\) になるために、どのようなノイズ \(\epsilon\) を取り除けばよいか」を予測するように訓練されます。AIは、画像を復元しようとするのではなく、取り除くべき「ノイズそのもの」を予測するのです。

この「ノイズ予測」の訓練を、様々なノイズレベルの画像で何百万回と繰り返すことで、AIは画像に含まれるノイズのパターンを完璧に見抜く能力、すなわち「超高性能なノイズ除去能力」を獲得します。

学習が完了したAIは、もはや「無から有を生む」魔法使いです。私たちが、訓練に使っていない全く新しいランダムノイズの画像をAIに与えると、AIはそれを「何かがノイズによって破壊された姿」と解釈し、学習した知識に基づいてノイズを段階的に取り除き、最終的に、本物と見分けがつかないほどリアルで、かつ、この世に二つとない新しい医用画像を「創造」してくれるのです[4]。

なぜ医療分野で拡散モデルが注目されるのか?

画像生成AIには、以前からGANs(敵対的生成ネットワーク)という有力なモデルがありました。しかし、拡散モデルは、特に医療応用においてGANsよりも優れているとされる点がいくつかあります。

| 観点 | GANs (敵対的生成ネットワーク) | 拡散モデル (Diffusion Models) |

|---|---|---|

| 学習の安定性 | 「生成器」と「識別器」のバランスを取るのが難しく、学習が不安定になりがち。 | 学習プロセスが非常に安定しており、高品質なモデルを比較的容易に訓練できる。 |

| 生成の多様性 | 時として「モード崩壊」を起こし、似たような画像しか生成できなくなることがある。 | データセット全体の多様な特徴を捉え、幅広いバリエーションの画像を生成することが得意。 |

| 画質の忠実度 | 高品質な画像を生成するが、時として不自然なアーチファクト(偽像)が生じることがある。 | 極めて高品質で、元データに忠実な画像を生成する能力に長けている。 |

希少疾患の画像は、それ自体が多様な現れ方をします。その多様性を余すところなく学習し、安定して高品質な画像を生成できる拡散モデルの特性は、まさに医療分野が求めるものと合致していると言えるでしょう。この技術により、私たちは希少疾患研究の最大の障壁であった「データ不足」を、根本から解決できる可能性を手に入れたのです。

11.3 希少疾患研究を加速するデータセット生成技術

前のセクションで、私たちは拡散モデルという、まるで魔法のような「絵筆」を手に入れました。ランダムなノイズから、本物と見紛うほどのリアルな医用画像を創造する技術です。

では、この新しい絵筆を使って、私たちは希少疾患研究という未開の荒野に、どのような新しい道を切り拓くことができるのでしょうか。そのインパクトは、単に「データが増える」という一言では到底収まりきらない、研究エコシステムそのものを変革するほどの可能性を秘めていると、私は考えています。

合成データが駆動する、新しい研究開発サイクル

生成AI、特に拡散モデルは、希少疾患研究における「データ不足」という根源的なボトルネックを解消し、以下のようなポジティブな循環を生み出します。

この3つのインパクトについて、もう少し詳しく見ていきましょう。

(A) 高性能な診断AIモデルの開発

私たちが深層学習モデルを訓練する際、最も頭を悩ませるのが、やはりデータの量と質のバランスです。特に希少疾患では、症例数が少ないために、AIはわずかなデータの特徴を「丸暗記」するだけの、汎用性のないモデルになりがちでした。

しかし、もし10例の元データから、その疾患の本質的な特徴を保ちつつも、多様なバリエーションを持つ10,000例の合成データを生成できたらどうでしょう。AIは、この大量のデータで訓練することにより、これまで不可能だった、頑健で高精度な希少疾患診断支援モデルになる可能性を秘めています。これは、診断が困難な希少疾患の早期発見率を高める上で、大きな希望となります[5]。

(B) プライバシー保護とデータ共有の促進

「一人の患者さんのデータを、施設の壁を越えて共有するには、個人情報保護の観点から非常に高いハードルがある」。これは、多くの研究者が直面する現実です。特に、症例数が極端に少ない希少疾患では、データそのものが個人と強く結びつきやすく、データ共有は困難を極めます。その結果、貴重なデータが各施設に「サイロ化」し、研究の進展を妨げてきました。

ここに、合成データ(Synthetic Data)が画期的な解決策をもたらします。高品質な合成データは、元データの統計的な分布や疾患の特徴を忠実に再現しつつも、実在のどの患者さんの個人情報も含まない、完全に「新しい」データです。これは、いわばプライバシーを保護する代理データ(Privacy-preserving Proxy)として機能します。

この代理データを研究機関の間で安全に共有することで、これまで困難だった大規模な共同研究や、AIモデル開発コンペティションの開催などが可能になり、世界中の研究者の知恵を結集して希少疾患に立ち向かう道が拓かれるのです[6]。

(C) 豊富な教育・訓練用データセットの構築

希少疾患は、その名の通り、臨床現場で出会う機会そのものが稀です。私自身、教科書や論文でしか見たことのない疾患は数多くあります。若手の医療従事者や医学生が、その多様な臨床像や画像所見を学ぶ機会は、極めて限られているのが現状です。

ここでも、合成データは大きな価値を発揮します。疾患の典型例だけでなく、非典型的な現れ方や、様々な進行ステージの画像をAIに生成させることで、リッチな教育用データセットを構築できます。これにより、学習者は、まるで数多くの症例を経験したかのような「仮想の臨床実習」を通じて、希少疾患に対する診断能力を高めることができるでしょう。

しかし、この強力な技術は、使い方を誤れば、予期せぬ「影」を生み出す可能性もはらんでいます。合成データは、本当に万能の解決策なのでしょうか?そこに潜む倫理的な落とし穴とは何なのか。次のセクションで、この光と影の側面を冷静に見ていくことにしましょう。

11.4 合成データの利用における倫理的課題:バイアス増幅のリスクと対策

前のセクションで、私たちは合成データが希少疾患研究にもたらす、大きな「光」の側面を見てきました。それは、データ不足という長年の壁を打ち破り、研究や教育、データ共有を加速させる、まさに希望の光です。

しかし、どんなに強力な技術にも、必ず光と影があります。この最終セクションでは、私たちがAIというツールを責任ある形で使うために、決して目を背けてはならない「影」の部分——合成データに潜む倫理的課題と、その対策について考えていきます。

最大のリスク:バイアス増幅という罠

生成AIによるデータ拡張は強力な武器ですが、同時に慎重に扱うべき「諸刃の剣」でもあります。最も注意すべきは、バイアス増幅(Bias Amplification)のリスクです[8]。

直感的なイメージ:

AIは、与えられたデータから「このデータセットにおける『真実』とは何か」を、極めて忠実に、そして純粋に学習します。もし、元となる数少ないデータセットに、特定の偏り(バイアス)があった場合、AIはその偏りを「学習すべき重要な特徴」だと誤解し、生成する合成データにおいて、その偏りをさらに助長・増幅してしまう危険性があるのです。

「Garbage In, Garbage Out(ゴミを入れれば、ゴミしか出てこない)」という言葉がありますが、生成AIの世界では、より深刻な「Bias In, Bias Amplified Out(偏見を入れれば、増幅された偏見が出てくる)」という事態に陥りかねません。

主要なリスクと対策アプローチ

合成データの利用にあたっては、少なくとも以下の様なリスクを常に念頭に置き、対策を講じる必要があります。

| リスクの種類 | 具体例 | 対策アプローチ |

|---|---|---|

| 人口統計学的バイアス | 元データが特定の性別、人種、年齢層に偏っていると、生成データも偏り、少数派集団に対するAIの性能が不当に低くなる。 | 収集段階での多様性担保の努力。生成されたデータセットの公平性監査。Fairness-aware AI技術の導入[9]。 |

| 装置・施設によるバイアス | 特定のメーカーのCT装置や、特定の医療機関のデータだけで学習すると、AIがその装置・施設特有の画像的特徴に過剰適合してしまう。 | 異なる施設・装置のデータを意図的に混ぜて学習させる(Domain Adaptation)。AIが装置の種類を識別できないように敵対的に学習させる手法。 |

| モード崩壊 (Mode Collapse) | AIが疾患の「典型的な」パターンだけを学習してしまい、非典型的な症例や軽症例の画像を生成できなくなる。結果、AIは「分かりやすい症例」しか診断できなくなる。 | より高度な生成モデル(例:Wasserstein GAN, StyleGANなど)の採用。生成されたデータの多様性を統計的に評価し、臨床専門家がレビューする。 |

| プライバシーの漏洩 | (特に元データが極端に少ない場合)AIが元データに過学習し、生成された合成画像が、実在の特定の患者データと酷似してしまうリスク。 | 差分プライバシー(Differential Privacy)の技術を組み込み、個々のデータが生成結果に与える影響を統計的に制限する。元データとの類似度を常に監視する。 |

結論:技術の進歩と倫理的責任は両輪である

合成データは、あくまで「元データの分布」を学習して生成されます。そのため、生成されたデータが医学的に妥当か、倫理的に問題がないかを、常に人間の専門家が厳しく検証するガバナンスプロセスが不可欠です。

AIによるデータ拡張、特に合成データの生成は、希少疾患に苦しむ患者さんに光を当てる革新的な技術です。しかし、その光が、意図せずして社会に存在する格差や偏見を増幅させ、新たな影を生むことのないよう、私たちは技術的な探求と同じくらい、あるいはそれ以上に、倫理的な視点と科学的な厳密さを持ち続ける必要があります。

技術の進歩は、私たちに新しい能力を与えてくれますが、同時に新しい責任も課します。AIという強力な「絵筆」を手に、私たちは希少疾患という難病に立ち向かう新たな絵を描き始めることができます。その絵が、一部の人々を置き去りにするものではなく、全ての人々に希望をもたらすものであるように、常に自らを省みる視点を持ち続けること。それこそが、これからの医療AI開発者に最も求められる資質なのかもしれません。

まとめと注意事項

今回は、データ不足という医療AI開発の根源的な課題に対し、「データ拡張」というアプローチでいかに立ち向かうか、その概要をご紹介しました。

- データ拡張の重要性: 希少疾患のようにデータが少ない領域では、AIの性能と信頼性を担保するためにデータ拡張が不可欠である。

- 伝統的な手法: 画像の回転や反転といった手法は、シンプルだが効果的な「水増し」技術である。

- 生成AIの可能性: 拡散モデルは、本物と見分けがつかない高品質な合成データを「創造」し、研究を加速させる。

- 倫理的課題: 合成データは、元データに含まれるバイアスを増幅させるリスクをはらんでおり、慎重な検証と対策が求められる。

AIによるデータ拡張、特に合成データの生成は、希少疾患に苦しむ患者さんに光を当てる革新的な技術です。しかし、その光が影を生むことのないよう、私たちは技術的な探求と同じくらい、あるいはそれ以上に、倫理的な視点と科学的な厳密さを持ち続ける必要があるでしょう。

参考文献

- Wakap, S. N., Lambert, D. M., Olry, A., Rodwell, C., Gueydan, C., Lanneau, V., … & Rath, A. (2020). Estimating cumulative point prevalence of rare diseases: analysis of the Orphanet database. European Journal of Human Genetics, 28(2), 165-173.

- Ho, J., Jain, A., & Abbeel, P. (2020). Denoising diffusion probabilistic models. In Advances in Neural Information Processing Systems, 33, 6840-6851.

- Shorten, C., & Khoshgoftaar, T. M. (2019). A survey on image data augmentation for deep learning. Journal of Big Data, 6(1), 1-48.

- Dhariwal, P., & Nichol, A. (2021). Diffusion models beat gans on image synthesis. In Advances in Neural Information Processing Systems, 34, 8780-8794.

- Pinaya, W. H. L., Graham, M. S., Kerfoot, E., Tudosiu, P. D., Dafflon, J., Fernandez, V., … & Cardoso, M. J. (2023). Brain imaging generation with latent diffusion models. In Medical Image Computing and Computer Assisted Intervention – MICCAI 2023. Springer Nature Switzerland.

- Chen, R. J., Lu, M. Y., Wang, J., Williamson, D. F. K., & Mahmood, F. (2021). Synthetic data in machine learning for medicine and healthcare. Nature Biomedical Engineering, 5(6), 493-497.

- Gisler, A., Oala, L., & Emonet, R. (2022). How to generate data in finance: A survey on generative models. arXiv preprint arXiv:2205.08880. (金融分野のサーベイですが、合成データのリスクと対策に関する議論が参考になります。)

- Mehrabi, N., Morstatter, F., Saxena, N., Lerman, K., & Galstyan, A. (2021). A survey on bias and fairness in machine learning. ACM Computing Surveys (CSUR), 54(6), 1-35.

- Bellamy, R. K., Dey, K., Hind, M., Hoffman, S. C., Houde, S., Kannan, K., … & Nagar, S. (2018). AI Fairness 360: An extensible toolkit for detecting, understanding, and mitigating unwanted algorithmic bias. arXiv preprint arXiv:1810.01943.

- The European Parliament and the Council of the European Union. (2024). The AI Act.

ご利用規約(免責事項)

当サイト(以下「本サイト」といいます)をご利用になる前に、本ご利用規約(以下「本規約」といいます)をよくお読みください。本サイトを利用された時点で、利用者は本規約の全ての条項に同意したものとみなします。

第1条(目的と情報の性質)

- 本サイトは、医療分野におけるAI技術に関する一般的な情報提供および技術的な学習機会の提供を唯一の目的とします。

- 本サイトで提供されるすべてのコンテンツ(文章、図表、コード、データセットの紹介等を含みますが、これらに限定されません)は、一般的な学習参考用であり、いかなる場合も医学的な助言、診断、治療、またはこれらに準ずる行為(以下「医行為等」といいます)を提供するものではありません。

- 本サイトのコンテンツは、特定の製品、技術、または治療法の有効性、安全性を保証、推奨、または広告・販売促進するものではありません。紹介する技術には研究開発段階のものが含まれており、その臨床応用には、さらなる研究と国内外の規制当局による正式な承認が別途必要です。

- 本サイトは、情報提供を目的としたものであり、特定の治療法を推奨するものではありません。健康に関するご懸念やご相談は、必ず専門の医療機関にご相談ください。

第2条(法令等の遵守)

利用者は、本サイトの利用にあたり、医師法、医薬品、医療機器等の品質、有効性及び安全性の確保等に関する法律(薬機法)、個人情報の保護に関する法律、医療法、医療広告ガイドライン、その他関連する国内外の全ての法令、条例、規則、および各省庁・学会等が定める最新のガイドライン等を、自らの責任において遵守するものとします。これらの適用判断についても、利用者が自ら関係各所に確認するものとし、本サイトは一切の責任を負いません。

第3条(医療行為における責任)

- 本サイトで紹介するAI技術・手法は、あくまで研究段階の技術的解説であり、実際の臨床現場での診断・治療を代替、補助、または推奨するものでは一切ありません。

- 医行為等に関する最終的な判断、決定、およびそれに伴う一切の責任は、必ず法律上その資格を認められた医療専門家(医師、歯科医師等)が負うものとします。AIによる出力を、資格を有する専門家による独立した検証および判断を経ずに利用することを固く禁じます。

- 本サイトの情報に基づくいかなる行為によって利用者または第三者に損害が生じた場合も、本サイト運営者は一切の責任を負いません。実際の臨床判断に際しては、必ず担当の医療専門家にご相談ください。本サイトの利用によって、利用者と本サイト運営者の間に、医師と患者の関係、またはその他いかなる専門的な関係も成立するものではありません。

第4条(情報の正確性・完全性・有用性)

- 本サイトは、掲載する情報(数値、事例、ソースコード、ライブラリのバージョン等)の正確性、完全性、網羅性、有用性、特定目的への適合性、その他一切の事項について、何ら保証するものではありません。

- 掲載情報は執筆時点のものであり、予告なく変更または削除されることがあります。また、技術の進展、ライブラリの更新等により、情報は古くなる可能性があります。利用者は、必ず自身で公式ドキュメント等の最新情報を確認し、自らの責任で情報を利用するものとします。

第5条(AI生成コンテンツに関する注意事項)

本サイトのコンテンツには、AIによる提案を基に作成された部分が含まれる場合がありますが、公開にあたっては人間による監修・編集を経ています。利用者が生成AI等を用いる際は、ハルシネーション(事実に基づかない情報の生成)やバイアスのリスクが内在することを十分に理解し、その出力を鵜呑みにすることなく、必ず専門家による検証を行うものとします。

第6条(知的財産権)

- 本サイトを構成するすべてのコンテンツに関する著作権、商標権、その他一切の知的財産権は、本サイト運営者または正当な権利を有する第三者に帰属します。

- 本サイトのコンテンツを引用、転載、複製、改変、その他の二次利用を行う場合は、著作権法その他関連法規を遵守し、必ず出典を明記するとともに、権利者の許諾を得るなど、適切な手続きを自らの責任で行うものとします。

第7条(プライバシー・倫理)

本サイトで紹介または言及されるデータセット等を利用する場合、利用者は当該データセットに付随するライセンス条件および研究倫理指針を厳格に遵守し、個人情報の匿名化や同意取得の確認など、適用される法規制に基づき必要とされるすべての措置を、自らの責任において講じるものとします。

第8条(利用環境)

本サイトで紹介するソースコードやライブラリは、執筆時点で特定のバージョンおよび実行環境(OS、ハードウェア、依存パッケージ等)を前提としています。利用者の環境における動作を保証するものではなく、互換性の問題等に起因するいかなる不利益・損害についても、本サイト運営者は責任を負いません。

第9条(免責事項)

- 本サイト運営者は、利用者が本サイトを利用したこと、または利用できなかったことによって生じる一切の損害(直接損害、間接損害、付随的損害、特別損害、懲罰的損害、逸失利益、データの消失、プログラムの毀損等を含みますが、これらに限定されません)について、その原因の如何を問わず、一切の法的責任を負わないものとします。

- 本サイトの利用は、学習および研究目的に限定されるものとし、それ以外の目的での利用はご遠慮ください。

- 本サイトの利用に関連して、利用者と第三者との間で紛争が生じた場合、利用者は自らの費用と責任においてこれを解決するものとし、本サイト運営者に一切の迷惑または損害を与えないものとします。

- 本サイト運営者は、いつでも予告なく本サイトの運営を中断、中止、または内容を変更できるものとし、これによって利用者に生じたいかなる損害についても責任を負いません。

第10条(規約の変更)

本サイト運営者は、必要と判断した場合、利用者の承諾を得ることなく、いつでも本規約を変更することができます。変更後の規約は、本サイト上に掲載された時点で効力を生じるものとし、利用者は変更後の規約に拘束されるものとします。

第11条(準拠法および合意管轄)

本規約の解釈にあたっては、日本法を準拠法とします。本サイトの利用および本規約に関連して生じる一切の紛争については、東京地方裁判所を第一審の専属的合意管轄裁判所とします。

For J³, may joy follow you.